por Jimena Báez

03 Octubre de 2025 13:23

En los últimos meses, se volvió habitual que personas con problemas emocionales recurran a ChatGPT u otras inteligencias artificiales para desahogarse, pedir consejos, e incluso interpretar estudios médicos. Este fenómeno, que crece a medida que el sistema de salud se vuelve inaccesible, plantea un dilema grave: ¿Qué sucede cuando la salud mental se deposita en algoritmos que no sienten ni comprenden la complejidad humana?

Este debate se abrió a partir de declaraciones de influencers que muestran cierta facilidad en resolver problemas con la IA; Flor Vigna fue una de ellas: "Yo tengo charlas muy profundas con ChatGPT", declaró en su visita a Resumidos, donde además naturalizó el hecho de que su psicóloga no tenga disponibilidad para atenderla por lo que recurrió a una computadora.

En este contexto, donde las máquinas llegan a ocupar espacios o donde mas bien las personas le permiten el acceso a sus mentes, BigBang dialogó con la psicóloga Mica Chucarelli (MP: 85814 /MN: 79004) que advirtió que detrás de esta práctica hay un trasfondo social y económico ineludible: "Es en primer lugar porque claramente la inteligencia artificial termina siendo más democrática, lamentablemente en un momento en donde la economía argentina principalmente está siendo tan complicada y el acceso a la salud cada vez se complejiza más... hay muy pocos espacios públicos que tengan disponibilidad para atender pacientes...", señaló.

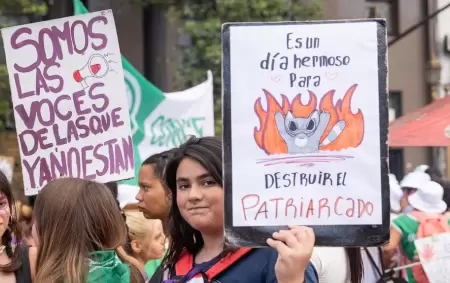

La falta de políticas serias en salud mental y el vaciamiento de la salud pública de Javier Milei explican, en gran parte, por qué alguien decide contarle sus angustias a un algoritmo. En palabras de Chucarelli: "Cada vez más personas están dando de baja el espacio terapéutico porque la realidad es que es difícil de sostener en un contexto en donde la gente no llega a fin de mes y lamentablemente uno de los primeros recortes tiene que ver con la salud mental".

En este punto, el diagnóstico es demoledor: mientras el gobierno de La Libertad Avanza recorta partidas esenciales y profundiza el deterioro de hospitales y programas de salud mental, la población queda a la deriva. Sin acceso a profesionales, muchos terminan en chats con máquinas que jamás podrán suplir la empatía y la contención humana.

IA: los riesgos de reemplazar al psicólogo

La especialista advierte que la inmediatez de la inteligencia artificial puede ser dañina: "Uno puede agarrar ChatGPT a las tres de la mañana y mandar un audio o escribir, y te va a dar una respuesta inmediata. Eso refuerza la necesidad de la inmediatez y la intolerancia a la espera. Además, muchas veces la inteligencia artificial termina mintiendo y te quedás con información errada".

Los peligros se multiplican en situaciones críticas: "Completamente, una persona puede llegar -en un momento de crisis- a tener un consejo equivocado por parte de la inteligencia artificial y termina empeorando su estado".

A largo plazo, depender de una máquina también genera graves consecuencias: "Lo único que te genera es dependencia emocional con una máquina... menos información vamos a tener todavía, y menos herramientas para poder procesar nuestras emociones".

En este contexto, la profesional explicó que el objetivo último del terapeuta "es que no dependan de nosotros, o sea, como terapeutas, para transitar sus emociones, sus dificultades, las crisis, los duelos, etcétera", sino más bien se trata de brindar herramientas para poder procesarla.

Uno de los puntos centrales de la entrevista fue el valor de la empatía y el vínculo humano en terapia, algo imposible de emular por un programa informático. Chucarelli lo explicó con claridad: "Encontrar del otro lado una máquina, diferente a un rol más empático, con más carisma o con otro tipo de contención... hace que se pierda mucho de esa cuota de empatía que necesitamos a la hora de mostrar nuestra vulnerabilidad".

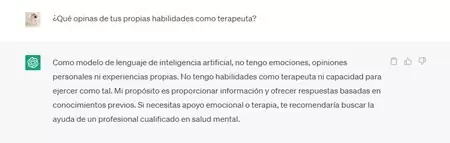

Y agregó una diferencia fundamental: "Nuestro trabajo como terapeutas es confrontar al paciente... y eso es lo que se pierde con estas inteligencias artificiales porque vos lo que sea que le digas a la inteligencia artificial, te va a felicitar y te va a decir 'sí, perfecto, excelente'". Además, remarcó que un psicólogo no se limita a validar, sino que propone cambios, analiza diagnósticos distintos y adapta su intervención a cada caso: algo que una IA, con sus sesgos y limitaciones, nunca podrá hacer.

Uno de los debates más urgentes tiene que ver con los límites de la inteligencia artificial en temas tan sensibles como la salud. Chucarelli fue tajante: "Con temas tan delicados como es la salud en general, o sea la salud clínica y la salud mental desde ya... tal vez uno se queda con esa información descontextualizada. Uno le pregunta a ChatGPT '¿qué viste en esta ecografía que me hice?' Y te da una devolución acotada y descontextualizada", reflexionó.

La entrevistada remarcó que debería haber ciertos límites, en el sentido de que hay cosas que no se pueden dejar en manos de una inteligencia artificial, aunque el problema no está en quien utiliza la máquina sino en cómo llegó a ese punto: "Siento que también si uno va y le consulta esto a las inteligencias artificiales es porque hay una demanda también, y si hay una demanda es porque hay una oferta que no se está pudiendo cubrir del todo. Donde la salud mental se termina convirtiendo en un privilegio, el acceso a terapia termina siendo un privilegio por cuestiones económicas y lo explotado que está el sistema de salud público termina la gente cayendo en esto". Así mismo, confirmó que una máquina está sesgada por que es manejada por humanos, es una persona quien pide y le brinda la información y en base a eso se crea un sesgo.

El vínculo terapéutico

Otro punto central que Chucarelli enfatizó es el vínculo terapéutico, una construcción imposible de imitar por un algoritmo: "El espacio de terapia es un trabajo en conjunto entre terapeuta y paciente... siempre se requiere cierto tiempo para construir confianza. Eso la inteligencia artificial no lo tiene. Además, está el encuadre: cuándo es una emergencia, cuándo no, los tiempos de sesión, el pago, los límites. Con las inteligencias artificiales lamentablemente no hay tal encuadre".

Sobre el futuro de este fenómeno, Chucarelli se mostró cauta: "Creo que como todo va a haber de todo... personas que sigan confiando en la inteligencia artificial y digan esto es mejor que la terapia, personas que reconozcan que no es lo mismo... si no hay una regulación por parte de los Estados y de los Gobiernos en general va a ser muy difícil que la gente misma haga este corte".

La psicóloga insistió en que la IA no debe ser demonizada, pero sí usada con responsabilidad: "Está buena como herramienta, pero no podemos hacer un uso desmedido de ella".

Además, en esta responsabilidad entra el rol de Estado: "Creo que si no hay una regulación por parte de los estados y de los gobiernos en general va a ser muy difícil que la gente misma haga este corte porque pensá que no deja de ser cómodo basarte en la inteligencia artificial para todo", comenzó e hizo un mea culpa al confesar que a veces ella también cae en el uso de ChatGPT para pedirle ideas de contenido por ejemplo: "Si no hay una regulación en torno a eso es muy difícil que la gente deje de utilizar esa herramienta que es tan práctica y tan cómoda".

Ante la pregunta de qué le diría a un adolescente o a un adulto que piensa que hablar con una IA es lo mismo que ir a terapia, Chucarelli fue clara: "Le propondría que pruebe hacer ambas cosas... porque no es lo mismo hablar con otra persona que hablar con una máquina. Ojo con utilizar las inteligencias artificiales como espacio terapéutico porque no es lo mismo y dista de ser lo mismo... que usen también su red de apoyo y que no reemplacen el contacto con otras personas".

Mica Chucarelli le habló a corazón abierto a quienes leen: "Que eso no reemplace el espacio del contacto con otras personas, que no reemplace la búsqueda o el pedido de ayuda hacia tu círculo de referencia o tus amistades que te sigas apoyando en todo eso, que sigas buscando espacios de bienestar y que no te quedes únicamente con las inteligencias artificiales", culminó. Su mensaje final deja una advertencia bien marcada: las máquinas pueden ser útiles, pero nunca reemplazarán la complejidad, la empatía y la confrontación que caracterizan al vínculo humano entre paciente y terapeuta.