16 Septiembre de 2025 14:40

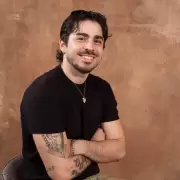

Las declaraciones de Flor Vigna siempre generan repercusiones y su entrevista en Mano a Mano (espacio de Resumido) no fue la excepción. La artista contó que recurre a ChatGPT para conversar sobre temas íntimos y emocionales, una práctica que muchos consideran preocupante cuando se trata de salud mental. La inteligencia artificial demostró ser una herramienta potente para resolver tareas concretas: resumir textos, generar ideas, automatizar procesos. Pero es importante dejar claro que la IA no tiene diagnóstico clínico, ni formación ética ni responsabilidad profesional. Está diseñada para generar respuestas basadas en patrones y datos; por eso puede ofrecer mensajes reconfortantes o sugerencias generales, pero no puede evaluar riesgos, detectar un cuadro psicopatológico ni ofrecer intervenciones terapéuticas seguras.

Flor Vigna relató que, en momentos de confusión, mantuvo conversaciones con ChatGPT porque "mi psicóloga no tenía turno". Eso revela una urgencia real: cuando el acceso a un profesional falla, la tentación de buscar consuelo rápido aumenta. El problema es que una máquina tiende a devolver lo que el usuario espera leer. "No me encuentro, me siento media frustrada, creo que ya no me gusta tanto lo que antes me gustaba", dijo Vigna en una charla con ChatGPT.

Y reveló la respuesta que obtuvo: "Tranqui no te está gustando la exposición de la industria y la presión de la industria, pero si te gusta actuar, si te gusta bailar, si te gusta cantar pero no te gusta la presión de la industria".

Comentarios así pueden sonar certeros, pero no sustituyen una evaluación clínica, un seguimiento terapéutico ni la escucha humana experta. Además, dejar la salud mental en manos de un algoritmo relaja la responsabilidad humana de acompañar y de derivar a redes profesionales cuando hace falta. "Yo tengo charlas muy profundas con ChatGPT", declaró la cantante y siguió: "En España charlé un montón con ChatGPT porque estaba ahí media perdida con algunas cosas, mi psicóloga no tenía turno entonces hablaba con ChatGPT", confesó sin darle importancia a la gravedad del asunto.

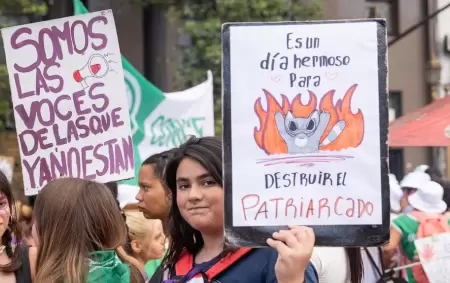

La viralización del clip en redes profundizó la polémica. Entre las reacciones hubo quienes celebraron la sinceridad de Vigna y quienes advirtieron sobre el peligro de confiar en herramientas digitales para tratar angustias, dudas existenciales o trastornos. Esa división subraya algo elemental como que la tecnología debe complementar, nunca reemplazar, el trabajo de profesionales de la salud: "Flor 30 años tenes criatura, nadie te obliga a permanecer en el ambiente si así no lo deseas, es simple como entender de qué va" o "No poder confiar en una IA antes que en un psicólogo en la vida real. Media pila, después se preguntan porque viven con trastornos de cualquier cosa", fueron algunos de los comentarios destacados en X.

Si una persona se siente confundido, angustiado o en crisis emocional, estas recomendaciones son clave: buscar un profesional (psicólogo o psiquiatra), consultar el centro de salud más cercano o llamar a las líneas de atención. Es clave evitar usar chatbots o IAs como única vía de contención cuando hay riesgo o sufrimiento intenso, ya que pueden servir como apoyo informativo o para elaborar ideas, pero no tienen la capacidad clínica ni ética de una terapia humana.